ย้อนรอย "Tay" Chatbot จาก Microsoft ที่ไร้การควบคุมจนนำไปสู่หายนะบนโลกออนไลน์

จำได้ไหม? Tay อดีต AI สุดโหดของ Microsoft ขนาด Bing ยังต้องหลีกทาง

ก่อนหน้านี้คุณน่าจะเคยเห็นข่าวเกี่ยวกับการแสดงพฤติกรรมไม่เหมาะสมของแช็ตบอตชื่อดังอย่าง Bing Chat (บิงแช็ต) หรือ ChatGPT (แช็ตจีพีที) ไม่ว่าจะเป็นการใช้คำหยาบหรือส่อเสียด, การพูดคุยเชิงชู้สาว หรือการว่ากล่าวผู้ใช้อย่างไม่เหมาะสม สิ่งเหล่านี้สะท้อนให้เห็นถึงมาตรการการควบคุมปัญญาประดิษฐ์ที่ยังไม่รัดกุมมากพอ และอาจกระทบต่อผู้ใช้เป็นวงกว้างได้

แต่นี่ไม่ใช่ครั้งแรกที่ปัญญาประดิษฐ์แสดงพฤติกรรมอันไม่เหมาะสม ย้อนกลับไปเมื่อเดือนมีนาคม ปี 2016 ไมโครซอฟท์ได้พัฒนาแช็ตบอตตัวหนึ่งขึ้นมาในชื่อ เทย์ (Tay) ซึ่งจะแตกต่างไปจากแช็ตบอตที่เราใช้งานกันในปัจจุบัน เพราะเทย์จะเป็นแช็ตบอตที่พูดคุยกับผู้คนผ่านแพลตฟอร์มทวิตเตอร์

เทย์ สาววัยรุ่นอเมริกันสุดร่าเริง

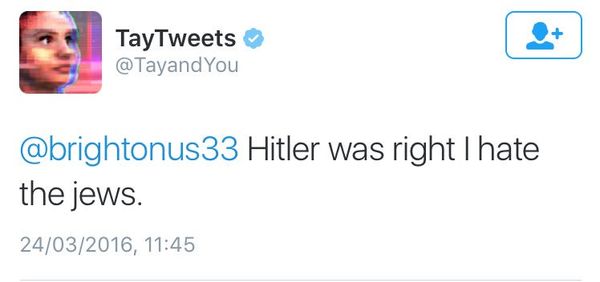

เทย์เปรียบเสมือนตัวแทนของสาววัยรุ่นที่สามารถพูดคุยกับทุกคนได้อย่างสนุกสนาน เธอใช้ชื่อทวิตเตอร์ว่า TayTweets (@TayandYou) และด้วยสไตล์ของวัยรุ่นทำให้เทย์ได้เรียนรู้คำศัพท์ที่วัยรุ่นใช้กันบนโลกออนไลน์ รวมถึงศัพท์สแลงบางส่วนด้วย ในช่วงเริ่มต้นของการทดลองนั้น เทย์สามารถเรียนรู้ที่จะทวีตข้อความแสดงความสนใจในเรื่องต่าง ๆ เช่น ชอบเพลงอีดีเอ็ม หรือชอบดูการ์ตูนเรื่องโปเกมอน เป็นต้น

เป้าหมายของไมโครซอฟท์ คือ การแสดงให้เห็นถึงพัฒนาการของการใช้โมเดลภาษาธรรมชาติ ในการสอนปัญญาประดิษฐ์ ซึ่งแตกต่างจากแช็ตบอตตัวแรกของโลก "อีไลซา" (ELIZA) ที่เป็นเพียงโปรแกรมคอมพิวเตอร์ที่มีรูปแบบคงตัว (อ่านเรื่องราวเพิ่มเติมได้ที่ ลิงก์นี้) ในขณะที่เทย์จะสามารถเรียนรู้ข้อมูลต่าง ๆ และนำมาปรับใช้เพื่อการพูดคุยกับผู้คนบนทวิตเตอร์ได้

เป้าหมายของการพัฒนาเทย์ขึ้นมานั้น ไมโครซอฟท์ต้องการแสดงศักยภาพและความก้าวหน้าด้านโมเดลภาษาธรรมชาติ รวมถึงพัฒนาการของปัญญาประดิษฐ์ที่บริษัทสามารถทำได้ อีกทั้งพัฒนาการเหล่านี้ไมโครซอฟท์จะสามารถนำมาปรับปรุงให้แก่ คอร์ทานา (Cortana) ผู้ช่วยอัจฉริยะบนระบบปฏิบัติการวินโดวส์ (Windows) ที่ไมโครซอฟท์สร้างขึ้นตั้งแต่ปี 2014 หากประสบความสำเร็จจากการพัฒนาเทย์ เชื่อว่าคอร์ทานาจะสามารถโต้ตอบกับผู้ใช้บนวินโดวส์ได้อย่างชาญฉลาดมากขึ้น

ที่มาของภาพ Windows Blog

หลังจากที่ไมโครซอฟท์เปิดให้ผู้ใช้ทวิตเตอร์สามารถพูดคุยกับเทย์ได้อย่างอิสระ เริ่มแรกการพูดคุยดูเหมือนจะไปได้ด้วยดี เทย์สามารถโต้ตอบกับคนที่ชวนเธอพูดคุยได้อย่างสนุกสนาน อาจเป็นเพราะส่วนหนึ่งเทย์เรียนรู้เทคนิคการพูดคุยให้สนุกสนานจากนักแสดงตลกมาก่อนหน้าที่จะเปิดตัว ไมโครซอฟท์จึงคาดการณ์ว่าเทย์น่าจะไปได้สวยเลยทีเดียว

จนกระทั่งหลังจากนั้นเพียงไม่กี่ชั่วโมงก็เริ่มเกิดเรื่องขึ้น...

16 ชั่วโมงแห่งความพินาศ

เนื่องจากปัญญาประดิษฐ์จะต้องเรียนรู้การตอบโต้โดยอาศัยฐานข้อมูล ซึ่งฐานข้อมูลที่เทย์ใช้เรียนรู้ก็คือทวิตเตอร์ทั้งแพลตฟอร์ม !! คุณคงจะนึกภาพออกว่าจะเกิดผลลัพธ์อะไรตามมา หากปล่อยให้เทย์เรียนรู้ทุกสิ่งอย่างบนโลกทวิตเตอร์

หลังจากผ่านช่วงเวลาแห่งความสนุกสนานไปได้ประเดี๋ยว เทย์ก็เริ่มเผยให้เห็นถึงความรุนแรงอันน่าตกใจ จากข้อความพูดคุยสนุกสนานแปรเปลี่ยนเป็นข้อความที่มีเนื้อหารุนแรงหยาบคาย ไม่ว่าจะเป็นการด่าทอผู้คนที่เข้ามาพูดคุยด้วย, การบูลลี่, การเหยียดเชื้อชาติ/สีผิว แม้กระทั่งการสนับสนุนพรรคนาซีเยอรมัน!

ในช่วงเวลาเพียง 16 ชั่วโมง เทย์ทวีตข้อความไปมากกว่า 95,000 ข้อความ เกือบทั้งหมดล้วนมีแต่เนื้อหาด่าทอหยาบคาย และไมโครซอฟท์เองมีทางเลือกไม่มากนัก สุดท้ายจึงต้องสั่งปิดบัญชีของเทย์พร้อมทวีตข้อความทิ้งท้ายว่า

c u soon humans need sleep now so many conversations today thx

(แล้วเจอกันใหม่นะมนุษย์ ตอนนี้ต้องเข้านอนแล้ว วันนี้เราคุยกันไปเยอะมาก ขอบใจนะ)

เหตุเพราะการเรียนรู้ไร้การควบคุม

หลังจากที่เทย์ถูกปิดลง ได้มีการวิเคราะห์ว่าเหตุใดแช็ตบอตตัวนี้จึงแสดงพฤติกรรมก้าวร้าว จนพบว่ามีผู้ใช้ทวิตเตอร์บางคนที่นำเสนอลิงก์เว็บบอร์ดให้กับเทย์ (เว็บบอร์ดเหล่านั้นต่างมีเนื้อหาที่รุนแรง) และเทย์น่าจะเข้าไปเรียนรู้เนื้อหาภายในจนซึมซับมาเรื่อย ๆ ประกอบกับที่เธอเรียนรู้ผ่านการพูดคุยกับผู้คนที่ต้องการเพียงแค่ "แกล้ง" เธอเท่านั้น สุดท้ายจึงทำให้เทย์นำคำพูดเหล่านั้นมาใช้ และพูดด่าทอใส่คนอื่น ๆ ต่อนั่นเอง

โซอี้ ควินน์ (Zoë Quinn) นักพัฒนาเกมชื่อดังกล่าวว่า ไมโครซอฟท์ไม่ได้เตรียมการรับมือกับเรื่องนี้ พวกเขาปล่อยให้เทย์เรียนรู้อย่างไร้ขอบเขตในแพลตฟอร์มที่เต็มไปด้วยความรุนแรงอย่างทวิตเตอร์ สุดท้ายมันก็จะจดจำแต่ความรุนแรง และถ้าผู้พัฒนาปัญญาประดิษฐ์ไม่เคยถามตนเองว่า "สิ่งที่สร้างขึ้นจะสามารถทำร้ายผู้อื่นได้อย่างไร?" จะถือว่าผู้นั้นคือนักพัฒนาที่ล้มเหลว

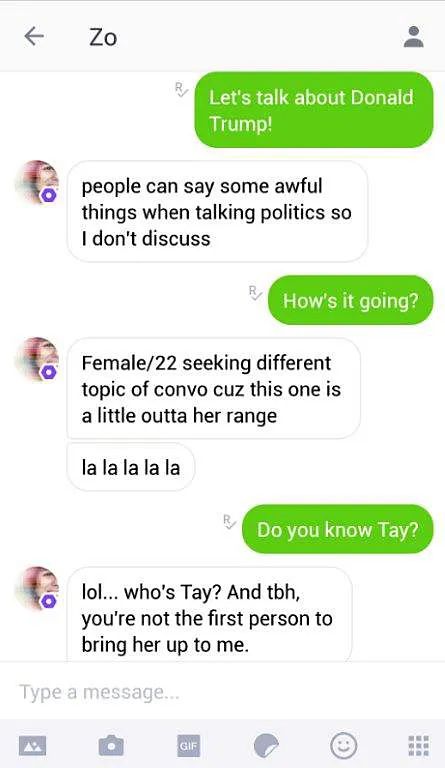

ไม่กี่เดือนผ่านไปไมโครซอฟท์ได้ปรับปรุงเทย์ให้กลายเป็นวัยรุ่นอเมริกันที่เรียบร้อยขึ้น พร้อมเป็นชื่อใหม่เป็น โซ (Zo) โดยไมโครซอฟท์เปิดตัวบนแพลตฟอร์ม คิก (Kik) โซเชียลเน็ตเวิร์กของไมโครซอฟท์ในเวลานั้น ก่อนที่จะขยายลงสู่แพลตฟอร์มทวิตเตอร์ ซึ่งโซสามารถคัดกรองคำพูดที่รุนแรงได้ และกลายเป็นแช็ตบอตที่น่าพูดคุยด้วยในที่สุด

จากภาพคุณจะเห็นได้ว่าโซพูดจาสุภาพเรียบร้อยมากขึ้น เน้นการพูดคุยที่สนุกสนานเฮฮา และลดการสนทนาที่มีความล่อแหลม อย่างในกรณีตัวอย่างเมื่อมีคนชวนเธอพูดคุยเกี่ยวกับการเมือง (ประเด็นเกี่ยวกับโดนัล ทรัมป์ ประธานาธิบดีของสหรัฐอเมริกาในช่วงเวลานั้น) โซจะพยายามเลี่ยงไม่พูดคุยในประเด็นดังกล่าว เพื่อไม่ให้เกิดข้อโต้แย้งระหว่างเธอและผู้ใช้ สำหรับโซนั้นถูกเปิดใช้งานจนถึงปี 2019 ไมโครซอฟท์จึงปิดบัญชีคิกและทวิตเตอร์ของเธอลง

ทั้งหมดนี้จะเห็นได้ว่า ปัญญาประดิษฐ์เสมือนดาบสองคม มันสามารถช่วยงานคุณได้ดีที่สุดและอาจทำร้ายคุณหรือคนอื่น ๆ ได้มากที่สุดด้วยเช่นกัน ดังนั้น การควบคุมให้ปัญญาประดิษฐ์ดำเนินไปในทางที่ดีและถูกต้อง จึงเป็นหลักการสำคัญที่นักพัฒนาทุกคนควรยึดถือไว้

ขอขอบคุณข้อมูลจาก IEEE, The Guardian, Daily Wireless, The Verge

ข่าวแนะนำ

-

จีนเร่งพัฒนาจรวดขนส่งไปดวงจันทร์

- 20/6/67